数据是当今最具价值的资产之一,保护数据已经成为企业的首要任务。因此,各大网站开始实施先进的反爬虫措施来保护其数据。如果您想高效地获取数据,了解这些反爬虫技术至关重要。本文将介绍热门的反爬虫技术,并讨论如何绕过它们!

什么是反爬虫?

反爬虫是网站采取的一系列技术和工具,用于防止未经授权的数据抓取。网站会通过多种方法来检测爬虫行为,比如监控访问流量是否存在异常模式,如单个 IP 地址在短时间内的过多请求。

CAPTCHA 测试也是区分真人用户和自动化机器人常用的方法之一。这只是当今网站使用的众多反爬虫技术中的一部分。接下来让我们一起深入探讨!

最受欢迎的 7 大反爬虫技术

下面我们来看看七种最常见的反爬虫技术,以及应对这些技术的策略。

1. IP 地址黑名单

IP 地址黑名单是网站用来限制单个 IP 地址在特定时间内发出请求数量的常见方法之一。这种方式可以有效识别并阻止频繁发送请求的爬虫。

首先,为了避免 IP 被封禁,建议不要使用真实 IP 地址进行爬虫。最好的方法是通过 高质量的轮换代理来进行 IP 轮换。这样做可以频繁更换 IP 地址,将请求分散到不同的 IP 上,减少被监测与屏蔽的概率。

如果您需要可靠、快速且稳定的网页爬虫代理服务,Bright Data 提供了多种适用于 不同使用场景的方案。通过数百万个 住宅代理和 数据中心代理,Bright Data 可为您提供高效、稳定的代理解决方案。

2. User-Agent 及其他 HTTP 头部过滤

User-Agent 过滤是另一种常见的反爬虫方法。网站会分析 HTTP 请求头中的 “User-Agent” 字符串,以区分并屏蔽非人类流量。许多爬虫依赖默认的 User-Agent 字符串,这对反爬虫工具来说很容易识别。

类似地,一些反爬虫系统会屏蔽未包含 Referrer 头的请求,该头用于说明发起请求的页面 URL。

其他常见的头部信息还包括 Accept-Language、Accept-Encoding 和 Connection 等浏览器通常会发送的头部字段,而爬虫因为它们对内容获取影响不大,往往会忽略这些头部。

要绕过这些检查,您可以使用热门浏览器或设备的 User-Agent 列表并进行轮换,同时包含上述提到的额外头部。

不过,一些网站会结合 User-Agent 信息和其他行为指标(如请求模式与 IP 声誉)来对比,从而更精准地识别爬虫。这也要求您定期更新 User-Agent 列表才能保持有效性,这个过程可能会耗时且难以维护。

使用 Bright Data 的 Web Scraper API 可以更好地解决这些问题。它是一款新一代的爬虫 API,内置自动 IP 轮换、User-Agent 轮换以及住宅代理等功能,让您能轻松绕过各种反爬虫机制。

3. JavaScript 挑战

网站常常使用 JavaScript 挑战来阻止自动化爬虫,形式包括 CAPTCHA、动态内容加载等需要执行 JavaScript 的方式。

解决这些问题的办法是使用 无头浏览器(如 Playwright 或 Selenium),它们可以像真人一样执行 JavaScript 并与网页交互。不过,Cloudflare 和 Akamai 等高级防护系统能够提供更复杂的 JavaScript 挑战,需要花费大量时间配置与调试,才能专注于编写爬虫逻辑。尽管如此,您仍可利用 Bright Data Scraping Browser 来绕过这些挑战。

Scraping Browser 内置网站解锁功能,能够自动处理各种封锁机制,包括 CAPTCHA 识别、自动重试以及为请求选择合适的头部、Cookie 与 JavaScript 渲染等。另外,Scraping Browser 能无缝集成 Puppeteer、Selenium 和 Playwright,为您提供完整的无头浏览器体验。

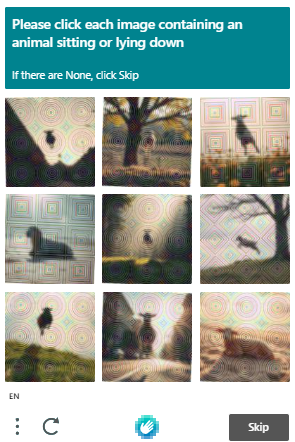

4. CAPTCHA 测试

CAPTCHA 是一种常见的反机器人保护系统,需要用户完成特定挑战来证明自己是人类。

这些挑战通常要求识别图片中的物体、解答谜题或输入扭曲的文本。CAPTCHA 的有效性在于它们对于自动化系统来说很难识别和解答。

许多 CDN(内容分发网络)服务(如 Cloudflare 和 Akamai)都将 CAPTCHA 集成到它们的反机器人保护中。如果系统检测到可疑流量,便会向用户自动弹出 CAPTCHA 测试。

幸运的是,市面上也出现了许多 CAPTCHA 识别工具,专门为解决这类问题而生。我们在 最好的 9 款 CAPTCHA 识别工具 一文中有详细讨论,大家可以根据速度、准确率、价格、可识别的验证码类型以及 API 集成等因素做出选择。

根据我的经验,Bright Data Web Unlocker 在成功率、速度和识别多种类型验证码方面表现突出。更多详细信息可参考 使用 Web Unlocker 绕过 CAPTCHA 的完整指南。

5. 蜜罐陷阱 (Honeypot)

蜜罐是一种简单但有效的方式,可以检测并阻止那些无法区分可见内容和隐藏内容的低级机器人。典型做法是在页面中植入人类用户看不到、但机器人可能抓取到的隐藏链接或表单。一旦爬虫与蜜罐进行交互,反爬虫系统就会自动屏蔽该爬虫。

要避免蜜罐陷阱,爬虫需要仔细分析网页的 HTML 结构,跳过那些对人类用户不可见、例如 "display: none" 或 "visibility: hidden" 的元素。另一种策略是使用 轮换代理,如果一个 代理服务器 IP 被蜜罐捕捉并封禁,也可以切换到其他代理继续访问。

6. 行为分析

行为分析通过长时间监控用户行为,以检测可能表明自动化爬虫的访问模式。机器人通常会展现可预测且重复的行为,如定时发送请求、访问顺序异常或在固定路径中依次抓取页面。网站也会监控一些指标,如会话时长、鼠标移动轨迹和交互时长等,以识别人机差异。

高级反机器人系统利用机器学习来适应新的爬虫技术。通过对海量用户交互数据进行模型训练,这些系统能够更加准确地分辨人类用户与机器人。由于机器学习算法可以针对不断变化的爬虫手段进行迭代更新,对爬虫来说难度更大。

要绕过这些系统难度较高,您可能需要使用高级的反爬虫服务。Web Unlocker 就是一种使用 AI 和机器学习的高级解决方案,专门应对并绕过这些封锁。它能够运用机器学习来确定最有效的绕过方式,并使用训练过的算法来定制指纹配置。

7. 浏览器指纹识别

浏览器指纹识别是网站收集浏览器信息的技术,包括屏幕分辨率、操作系统、语言、时区、已安装的扩展程序以及字体等。通过将这些细节组合起来,网站就能生成一个设备的独特识别码,用来追踪并屏蔽爬虫。为避免被浏览器指纹识别,您可以随机化这些特征,使网站更难建立一致的指纹。比如经常更换 IP 地址,使用不同的请求头(包括多种 User-Agent),以及在无头浏览器中设置不同的屏幕尺寸、分辨率和字体等。

虽然这些方法在一定程度上有效,但也存在操作复杂、维护成本高等风险。为了节约时间和精力并保证顺利的爬取过程,您可以考虑使用 Bright Data 的 Web Unlocker 或 Scraping Browser 等专门应对这些挑战的工具。

结论

本文介绍了当今主流的反爬虫技术及其应对方法。通过了解这些技术并实施先进的规避方案,您可以更有效地从网站中抓取所需的数据。

如果还想了解更多详细策略,我们有一篇关于 如何在不被封锁的情况下进行网页爬取 的文章,其中对各种解决方案都有深入讨论。

或者,您也可以使用 Bright Data 的 Scraping Browser 或 Web Unlocker 来简化整个过程,从而访问任何网站的数据,不受到任何限制。现在就开启免费的试用,注册请见下方!