本教程将介绍以下内容:

- 为何要使用 Bright Data 的 Web MCP 的工具来扩展 Ollama 模型?

- 您需要哪些工具才能进行扩展。

- 开始前您需要做的准备工作

- 如何使用 MCPHost 将 Web MCP 集成到 Ollama 模型中。

- 如何使用

ollmcp实现同样的结果? - 通过完整的示例演示您的本地 Ollama 模型将获得的新功能。

现在就来一探究竟吧!

为何要使用 Bright Data 的 Web MCP 来扩展 Ollama 模型

Ollama 提供多种可在本地运行的 AI 模型。然而,无论您选择哪种大语言模型,它们都有相同的局限性:它们的知识是静态的,仅限于其训练过的数据。

如何突破这种局限?让大语言模型从最大、最丰富的可用数据源,即网络,获取最新的实时数据。这正是 Bright Data 的 Web MCP 发挥作用的地方。

Web MCP 服务器扩展了 Ollama 模型的能力,使其能够检索最新的网络数据,并像人类一样与网页进行交互。这样,AI 模型就能克服其内建知识的局限性。

Web MCP 提供超过60种 AI 就绪型工具,所有这些工具均依托 Bright Data 的基础设施进行网络交互和数据收集。即使是在免费层级,您也可以使用两个非常有用的工具:

| 工具 | 说明 |

|---|---|

search_engine |

以JSON 或 Markdown 格式检索 Google、Bing 或 Yandex 搜索结果。 |

scrape_as_markdown |

绕过机器人检测和 CAPTCHA 验证,将任意网页内容提取为纯净的 Markdown 格式。 |

除此之外,Web MCP 还包括用于云浏览器交互的工具,以及数十种用于跨平台结构化数据订阅的专用工具,支持 YouTube、Amazon、LinkedIn、TikTok、Google Maps等平台。

添加 MCP 工具到 Ollama 模型

截至本文撰写之时,Ollama 桌面应用程序并不直接支持 MCP 集成(请参阅 官方 GitHub 问题更新)。这意味着,若要将 Ollama 模型与 MCP 工具集成,必须借助第三方解决方案。

要使用搭载 MCP 工具的 Ollama 模型,最常用的解决方案包括:

- MCPHost:一个 CLI 主机应用程序,允许大语言模型通过 MCP 与外部工具交互。它目前支持 Claude、OpenAI、Google Gemini 和 Ollama 模型。

- MCP Client for Ollama (

ollmcp):一个现代化的文本用户界面(TUI),可将本地 Ollama 大语言模型连接到一个或多个 MCP 服务器,从而实现高级工具使用和工作流程自动化。

其他可能的解决方案包括 Dolphin MCP、ollama-mcp-bridge 等等。在本指南中,我们将重点介绍前两种方法,因为它们的使用和支持最为广泛。

先决条件

在本节中,您将设置所有必要条件,以便在本地环境中使用 MCPHost 和 MCP Client for Ollama (ollmcp) 将 Bright Data Web MCP 与 Ollama 集成。

在开始之前,请确保您已经

- 在本地安装 Node.js(建议 下载最新的 LTS 版本),以便在本地运行 Bright Data Web MCP 服务器。

- 至少 16GB 内存和现代 CPU,以便在机器上流畅运行 Ollama。

对 MCP 的工作原理和 Web MCP 提供的工具有基本了解,也会有所帮助。

在本节结束时,您将完成以下准备工作:

- 完成 Ollama 的本地安装与配置,使其处于待命状态,随时可与 Bright Data Web MCP 集成

- 获得 Bright Data 账户及 API 密钥,用于 Web MCP 身份验证。

- 确认您的机器能够在本地成功运行 Web MCP 服务器。

请按照以下章节操作!

设置 Ollama

如果您还没有设置, 请为您的操作系统下载并安装 Ollama。然后,确保提取几个模型,如 gpt-oss、qwen3、deepseek-r1、llama3.2或你喜欢的其他模型。

使用以下命令提取模型:

ollama pull <model_name>将 <model_name> 替换为 一个可用的 Ollama 大语言模型的名称。

MCPHost 和 ollmcp 都需要 Ollama 才能在本地运行。那么,就 Ollama 开始吧:

ollama serve此命令以服务器模式启动 Ollama,无需打开桌面应用程序。

重要提示:默认情况下,Ollama 启动时的上下文长度限制为4096个令牌,这对于大型任务来说通常太低了。您可以使用以下命令将其增加到40,000个令牌(或所选模型支持的最大值):

在 macOS/Linux 上,运行:

OLLAMA_CONTEXT_LENGTH=40000 ollama serve或者,在 Windows (PowerShell) 上,执行:

$Env:OLLAMA_CONTEXT_LENGTH=40000; ollama serve这可确保您的 Ollama 模型能够处理更长的上下文而不会截断。

太好了!Ollama 现已配置完毕,可与 Bright Data Web MCP 服务器集成了。

获取 Bright Data API 密钥

Web MCP 服务器使用 Bright Data API 密钥进行验证。要获得密钥,首先创建一个 Bright Data 账户。如果您已有账户,只需登录即可。

然后,按照官方指南中的步骤生成 Bright Data API 密钥。将其存放在安全的地方,因为很快就会用到。

注意 :建议设置具有管理员权限的 API 密钥,因为这将使 Web MCP 集成过程更加顺畅。

本地测试 Web MCP

在将 Ollama 模型与 Bright Data Web MCP 集成之前,必须验证机器是否能够真正运行服务器。

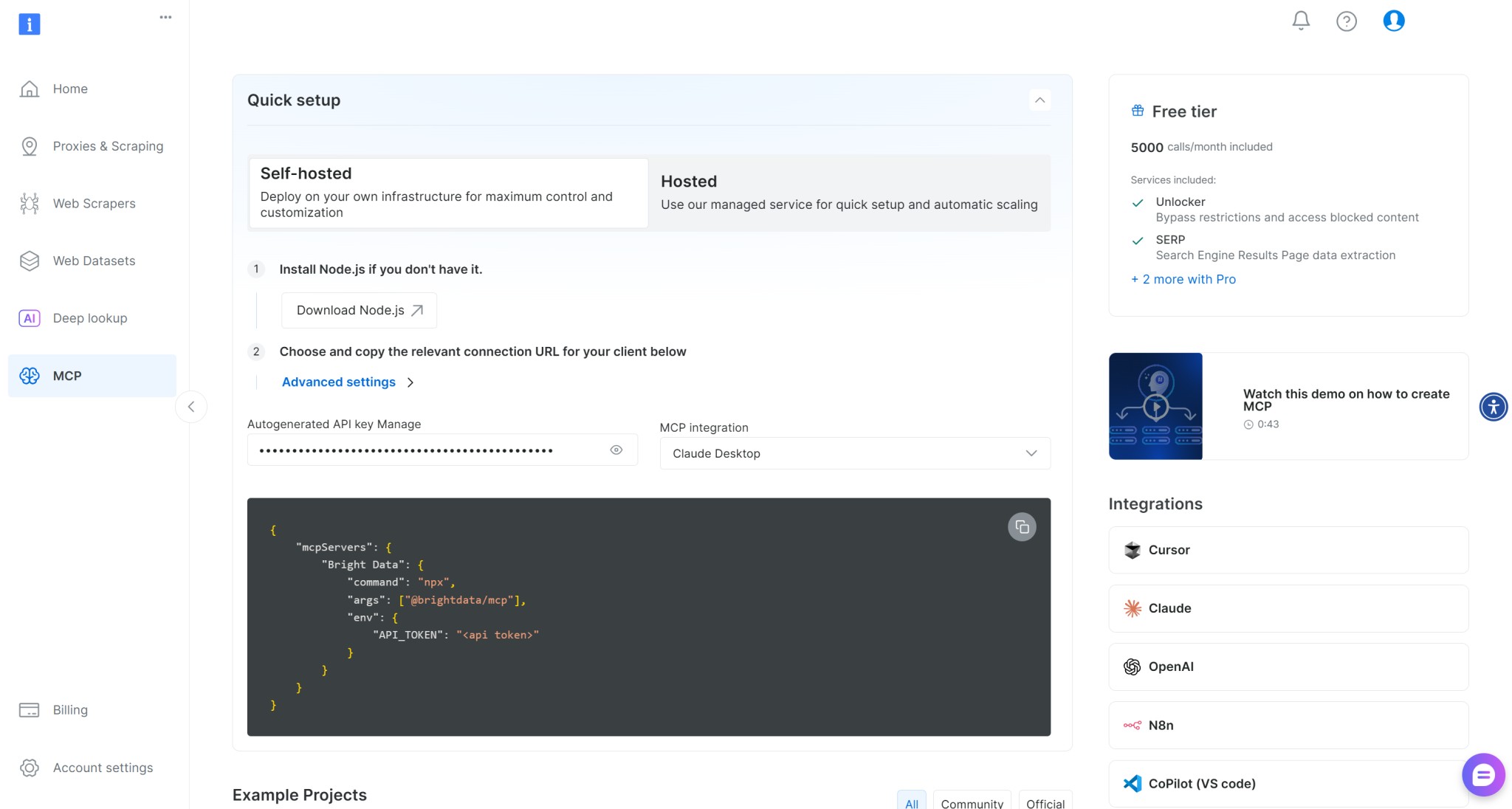

如需快速设置,请登录我们的 Bright Data 账户,参阅”MCP“页面中的说明:

如需更多指导,请按照以下说明操作。

通过 npm 命令在机器上全局安装 Web MCP:

npm install -g @brightdata/mcp执行以下命令,检查 MCP 服务器是否正常运行:

API_TOKEN="<YOUR_BRIGHT_DATA_API_KEY>" npx -y @brightdata/mcp如果是 PowerShell,则执行:

$Env:API_TOKEN="<YOUR_BRIGHT_DATA_API_KEY>"; npx -y @brightdata/mcp将 <YOUR_BRIGHT_DATA_API> 占位符替换为之前获取的 Bright Data API 令牌。这些命令会设置所需的 API_TOKEN 环境变量,并通过运行 @brightdata/mcp 软件包在本地启动 Web MCP。

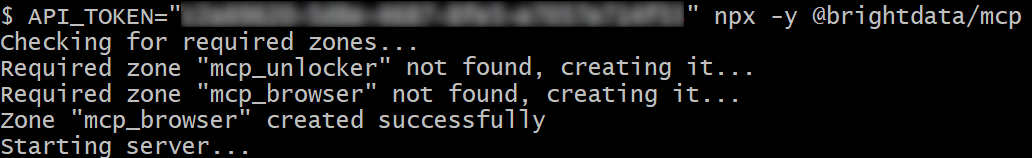

如果成功,您将看到类似下面的输出:

首次启动时,Web MCP 会自动在 Bright Data 账户中创建两个默认区:

mcp_unlocker:Web Unlocker。mcp_browser: Browser API。

Web MCP 依靠这两个 Bright Data 产品来为其 60 多个工具提供支持。

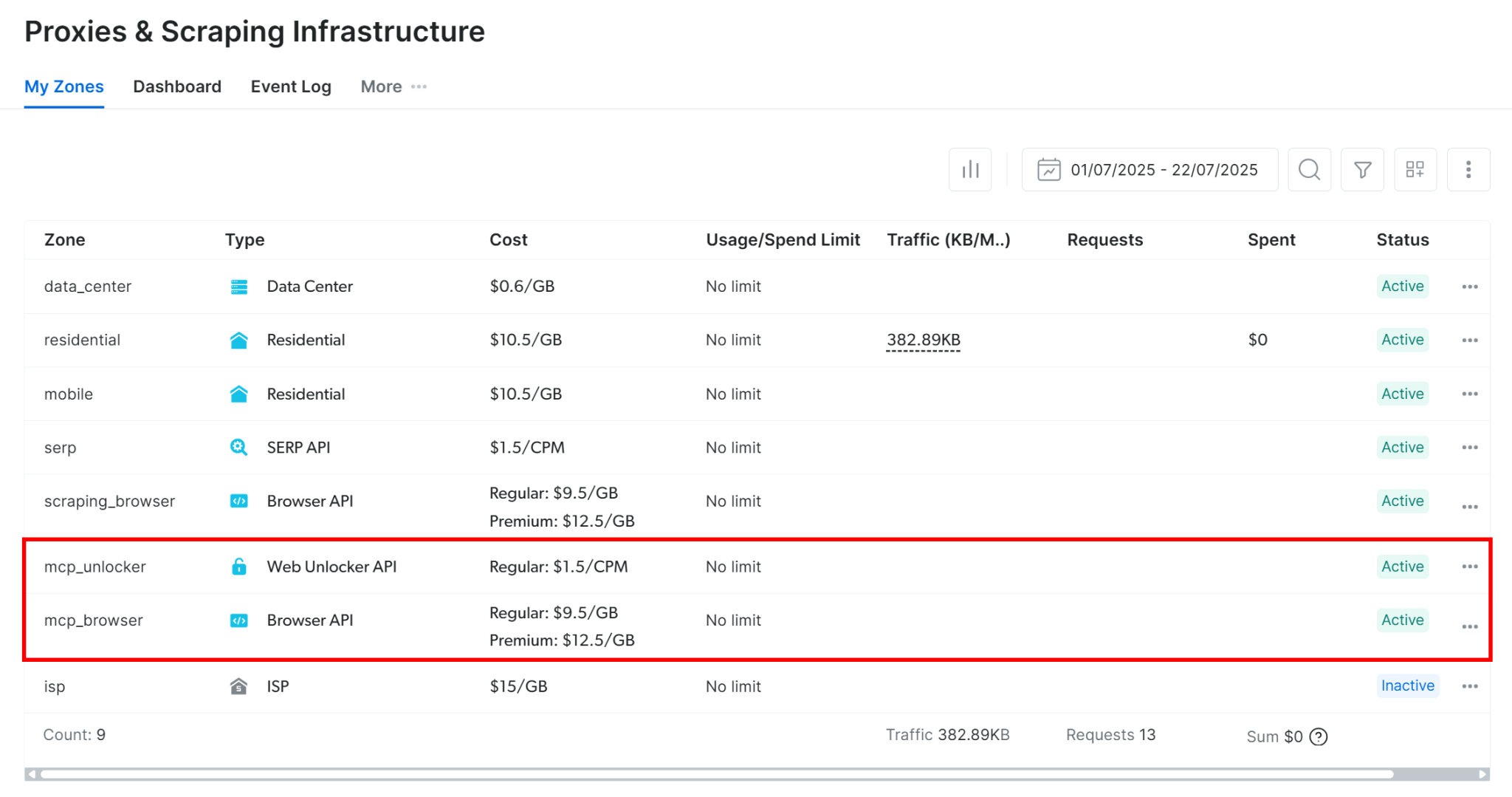

如果您想验证这两个区是否已设置,请访问”代理服务器和抓取基础架构“页面。您将在表格中看到两个区:

注意 :如果您的 API 令牌没有管理员权限,将无法创建这两个区。在这种情况下,您必须手动定义它们,并通过 GitHub 上所示的环境变量进行设置。

在Web MCP 免费层,MCP 服务器仅提供 search_engine 和 scrape_as_markdown 工具(及其批处理版本)。要解锁所有其他工具,您需要通过设置 PRO_MODE="true" 环境变量启用专业模式**:

API_TOKEN="<YOUR_BRIGHT_DATA_API>" PRO_MODE="true" npx -y @brightdata/mcp如果在 Windows 上,则执行

$Env:API_TOKEN="<YOUR_BRIGHT_DATA_API>"; $Env:PRO_MODE="true"; npx -y @brightdata/mcp专业模式可解锁全部 60 多种工具,但免费模式不包括这些工具。因此,会产生额外费用。

完美!您刚刚验证了 Web MCP 服务器可在您的计算机上运行。现在,停止 MCP 进程,因为下一步将配置 MCP 客户端,以启动并连接服务器。

如何使用 MCPHost 将 Bright Data Web MCP 整合到 Ollama 中

在本节中,您将逐步了解如何使用 MCPHost 将 Ollama 模型与 Bright Data Web MCP 的本地实例集成。

先决条件

除了之前的先决条件外,您还需要在系统中安装 Go 1.23 以上版本。这是设置并运行 MCPHost 的必备条件。

第1步:安装 MCPHost

go install github.com/mark3labs/mcphost@latest现在,您可以使用 mcphost 命令行工具启动 MCPHost。

注意:MCPHost 也可通过 SDK 在 Go 脚本中编程使用。

第2步:配置并熟悉工具

要启动搭载特定 Ollama 模型的 MCPHost,运行以下命令:

mcphost -m ollama:<model_name>将 <model_name> 替换为您希望 MCPHost 使用的 Ollama 模型名称。

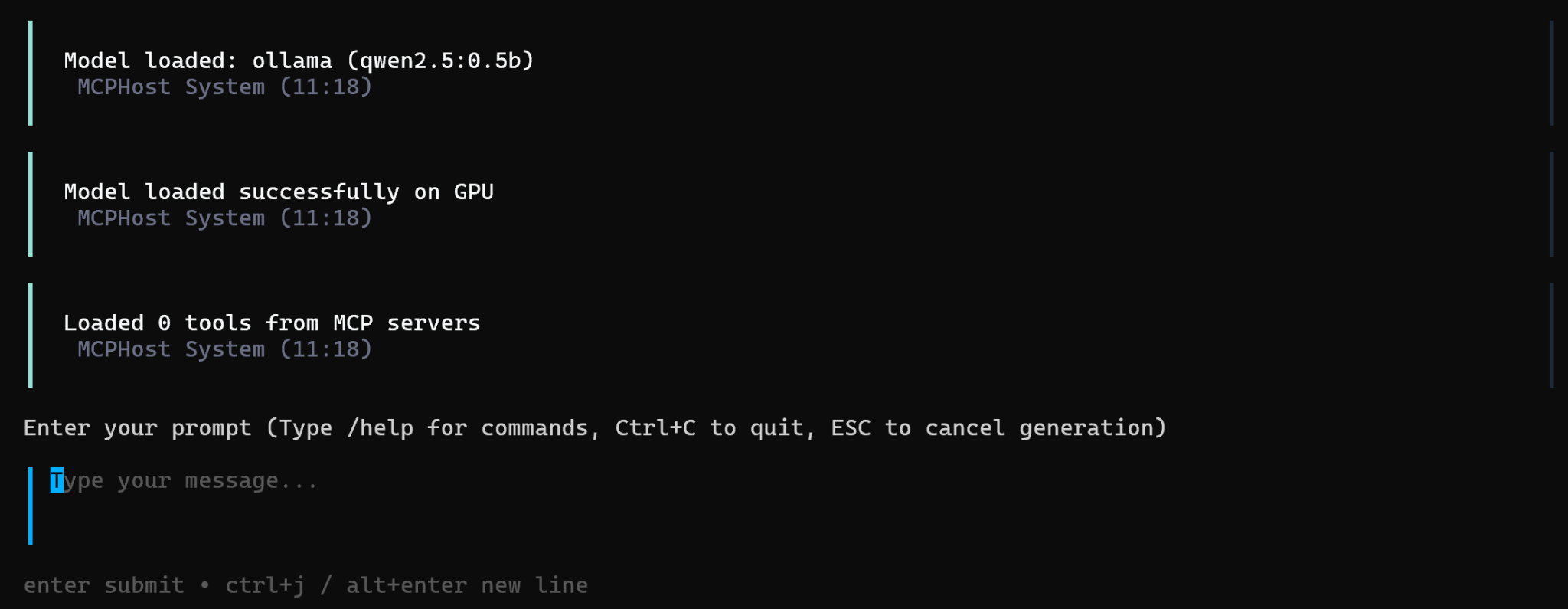

如果本地没有指定的模型,系统会自动为您提取。加载完成后,您在 CLI 中将看到的这个用户界面:

如需查看可用命令的完整列表,请参阅文档。例如,运行 /tools 命令将显示

此时看不到任何工具是正常现象,因为尚未配置 MCP 集成。

第3步:创建 Web MCP 连接配置文件

默认情况下,MCPHost 在 macOS 和 Linux 系统中会从 ~/.mcphost.yml 或~/.mcphost.json 文件中查找全局配置,而在 Windows 系统中则从 %USERPROFILE%.mcphost.yml 或 %USERPROFILE%.mcphost.json 文件中查找。

在这里,我们将定义使用本地 YAML 文件连接到 Web MCP 的配置。如果您喜欢全局配置,可以更新上述文件。

在项目文件夹中,创建名为 bd-web-mcp.yml 的文件,内容如下:

mcpServers:

bright-data-web-mcp:

type: "local"

command: ["npx", "-y", "@brightdata/mcp"]

environment:

API_TOKEN: "<YOUR_BRIGHT_DATA_API_KEY>"

PRO_MODE: "true"上述设置反映了之前使用的 npx 命令,利用了以下环境变量:

API_TOKEN必填。将其设置为您的 Bright Data API 密钥。PRO_MODE选填。如果不想启用专业模式,可以将其移除。

换句话说,此配置文件指示 MCPHost 如何在本地启动并连接 Web MCP 服务器。

第4步:将 Ollama 模型连接到 Web MCP**

现在,您可以使用以下命令启动 MCPHost,以便在 Ollama 中集成 Web MCP:

mcphost -m ollama:<model_name> --config "./bd-web-mcp.yml"例如,启动搭载 qwen2.5:0.5b 模型的 MCPHost:

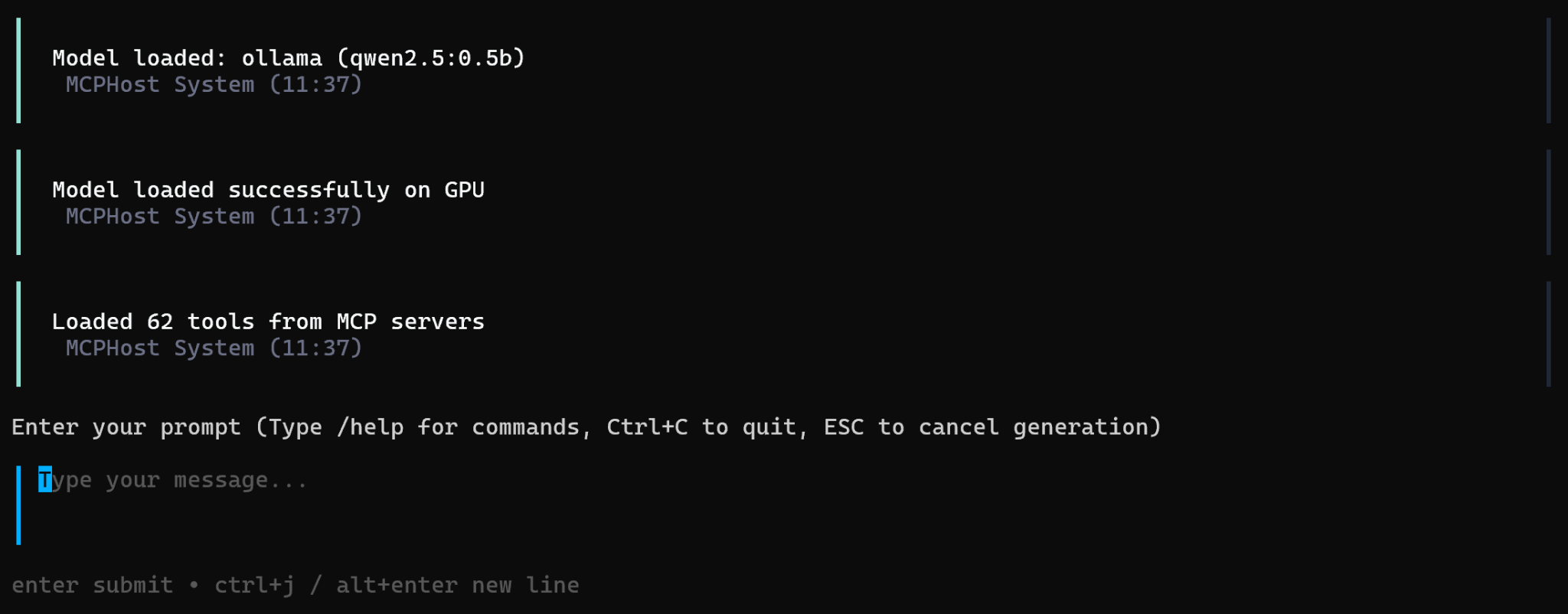

mcphost -m ollama:qwen2.5:0.5b --config "./bd-web-mcp.yml结果将如下所示:

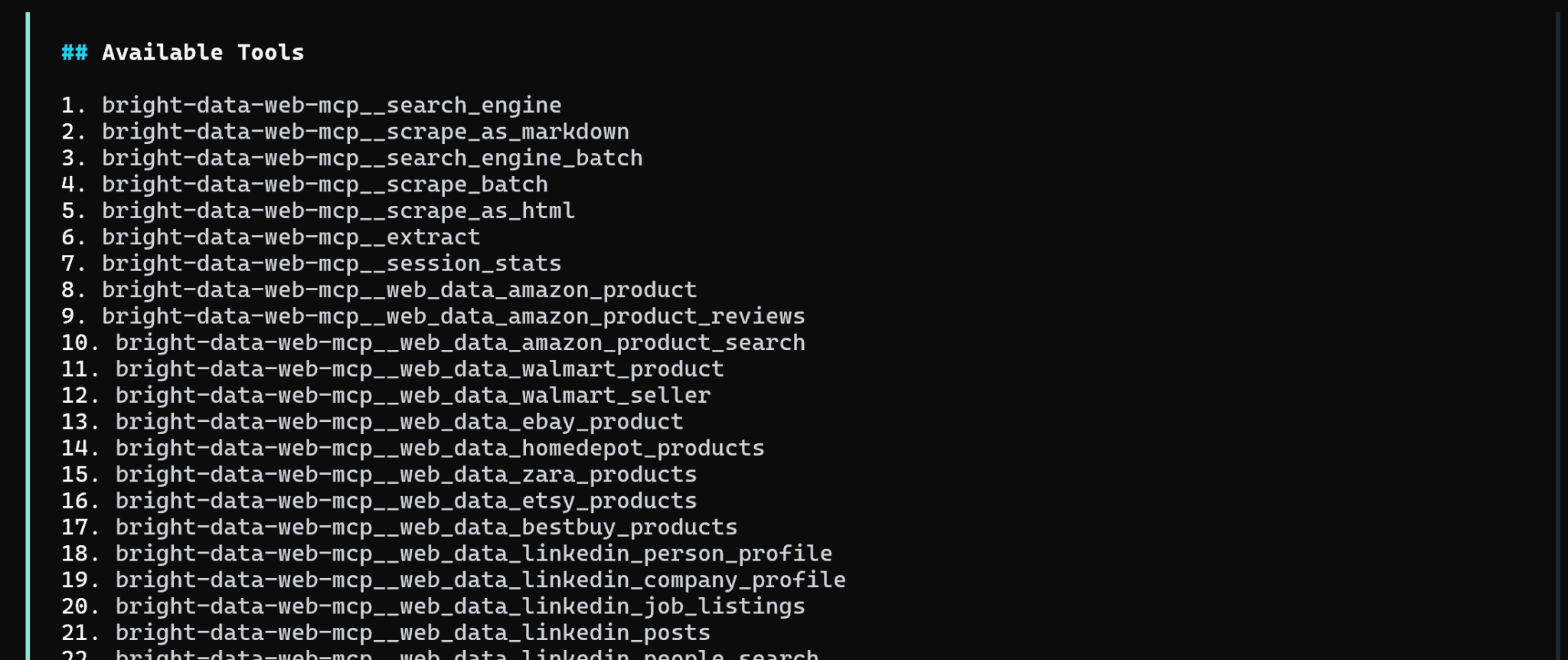

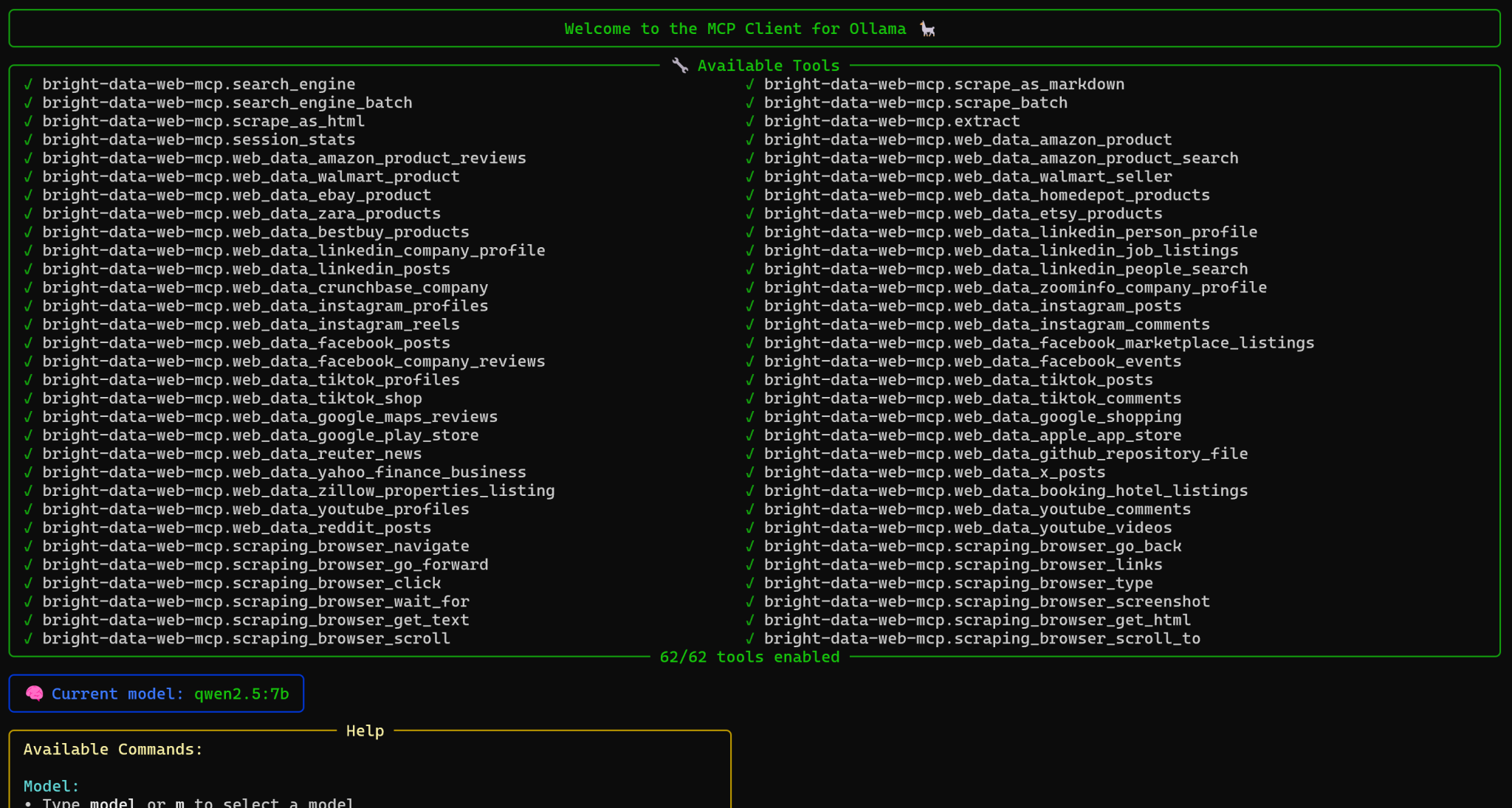

请注意,Ollama 模型现在可以访问本地 Web MCP 实例提供的 60 多种工具。您可以在 CLI 中运行 /tools 命令进行验证,会显示如下列表:

如果 MCP 服务器配置为专业模式,您将看到 60 多个工具。否则,只能使用免费层中的 4 个工具(search_engine、scrape_as_markdown 及其批处理版本)。

完成!您的 Ollama 模型现已配置完成,可与 Bright Data 的 Web MCP 工具配合使用。

通过 ollmcp 在 Ollama 中设置 Bright Data 的 Web MCP

本节将指导您使用 ollmcp,即 MCP Client for Ollama,将本地 Ollama 模型连接到本地 Bright Data Web MCP 服务器实例。

先决条件

要学习本节教程,除了前面的先决条件外,您还必须在本地安装 Python 3.10 或更高版本。这是安装和运行 ollmcp必备条件。

第1步:开始安装 ollmcp

使用以下命令在本地安装 ollmcp:

pip install --upgrade ollmcp注意:如果愿意,您也可以在虚拟环境中运行此命令。

启动 MCP Client for Ollama,验证其安装是否正确:

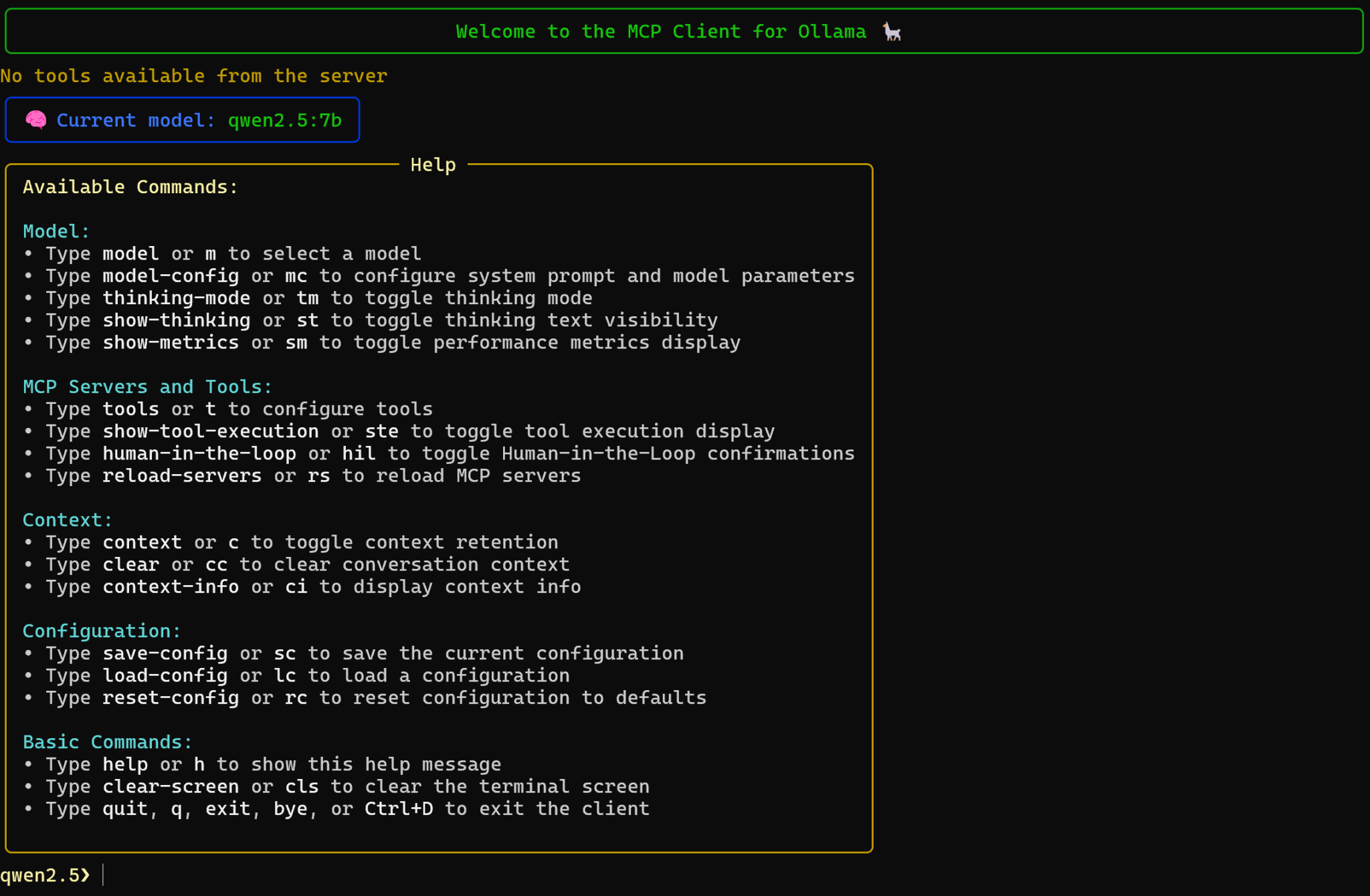

ollmcp您应该会看到下面的页面:

默认情况下,ollmcp 使用 qwen2.5:7b 作为初始模型。此外,请注意客户端尚未检测到任何 MCP 工具,这属于正常情况。

第2步:配置大语言模型

通过 --model(或 -m)标志启动搭载特定 Ollama 模型的 ollmcp。因此,发射命令将变成:

ollmcp --model <model_name>或者

ollmcp -m <model_name>其中 <model_name> 是您想使用的 Ollama 模型的名称。

另外,您也可以使用模型命令在 CLI 中配置模型:

然后选择要使用的模型。如需了解有关可用标志和选项的更多信息,请参阅官方文档。

第3步:添加 Web MCP 配置文件

ollmcp 支持多个 MCP 服务器集成选项:

--mcp-server,-s:一个或多个 MCP 服务器脚本路径(.py或.js)。可以多次指定。--mcp-server-url,-u:一个或多个 SSE 或可流 HTTP MCP 服务器 您可以多次指定。--servers-json,-j: 指向包含服务器配置的 JSON 文件的路径 具有特定格式。--auto-discovery,-a:从 Claude 的默认配置文件自动发现服务器(未提供其他选项时的默认行为)。

在本指南中,我们将使用自定义 JSON 文件 ,它类似于 Claude,是最简单的选项之一。

在项目文件夹中,创建名为 bd-web-mcp.json 的文件。输入以下内容:

{

"mcpServers": {

"bright-data-web-mcp": {

"command": "npx",

"args": ["-y", "@brightdata/mcp"],

"env": {

"API_TOKEN": "<YOUR_BRIGHT_DATA_API_KEY>",

"PRO_MODE": "true"

}

}

}

}上述设置反映了之前测试的 npx 命令,使用了这些环境变量:

API_TOKEN必填。用您的 Bright Data API 密钥替换<YOUR_BRIGHT_DATA_API_KEY>占位符。PRO_MODE选填。如果不想启用专业模式,可以将其移除。

简单地说,JSON 文件会告诉 MCP Client for Ollama 如何在本地启动并连接 Web MCP 服务器。

第4步:连接到Web MCP

使用 --servers-json 标志指定之前创建的 bd-web-mcp.json 文件,并连接到 Web MCP 服务器:

ollmcp --servers-json .bd-web-mcp.json您应得到如下页面:

您可以看到,ollmcp 中的模型现在可以访问本地 Web MCP 服务器实例提供的 60 多种工具。如果您在配置服务器时未启用专业模式,那么只有少数工具(如 search_engine、scrape_as_markdown及其批处理版本)可用。

您还可以在 CLI 中运行 tools 命令,列出所有可用工具:

您已成功将 Ollama 模型与 Web MCP 集成。任务完成!

在 Ollama 模型使用 Web MCP 工具

无论您选择以哪种方式在 Ollama 中集成 Web MCP,结果都是一样的:由 Bright Data Web MCP 服务器工具扩展的 Ollama 模型。

这意味着您的 Ollama 模型现在可以访问工具进行网络搜索、网络抓取、浏览器页面集成、网络数据检索等操作。这样,您的模型就能覆盖标准大语言模型通常无法使用的各种用例。

例如,您可以使用大语言模型通过网络搜索工具进行事实核查,使用抓取工具对给定 URL 的新闻文章提取摘要,在代理AI系统中进行网络交互,以及完成更多任务。

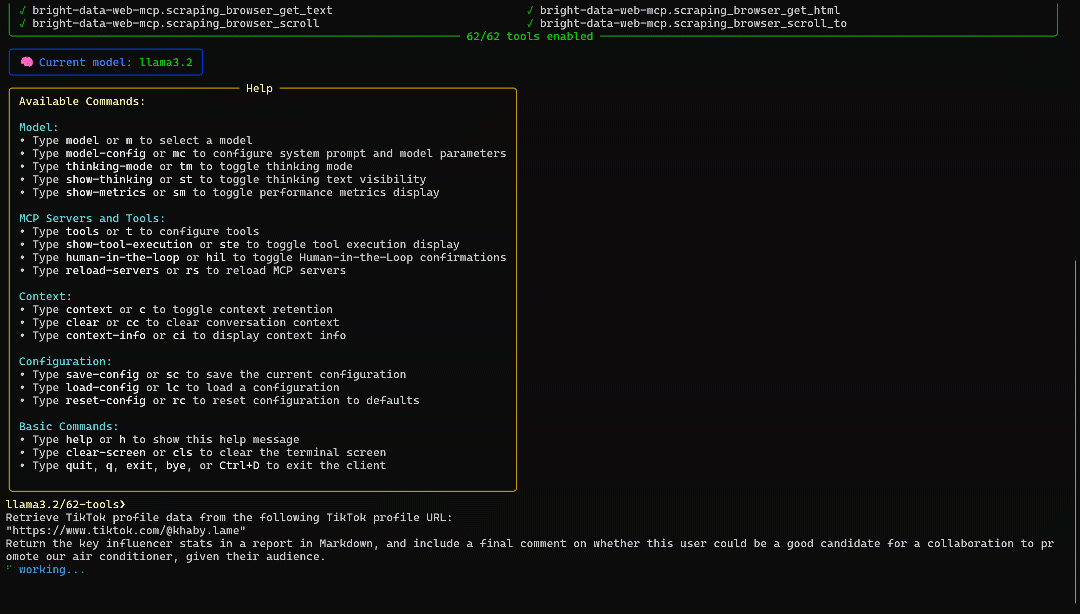

为了更好地展示 Web MCP 服务器的功能,请将其配置为专业模式。然后,使用搭载llama3.2 模型的 ollmcp(或 MCPHost):

ollmcp --model llama3.2 --servers-json .bd-web-mcp.json试试这样的提示词:

Retrieve TikTok profile data from the following TikTok profile URL:

"https://www.tiktok.com/@khaby.lame".

Return the key influencer stats in a report in Markdown, and include a final comment on whether this user could be a good candidate for a collaboration to promote our air conditioner, given their audience.这是需要网络数据检索能力的任务的一个绝佳范例。

结果将如下所示:

Ollama 模型会分析您的提示词,并从 Web MCP 中选择 web_data_tiktok_profiles 工具。该工具的定义是”快速读取结构化 TikTok 个人资料数据。需要有效的 TikTok 个人资料 URL。通常比抓取更快、更可靠”。因此,这是一个理想的工具选择。

您需要有权限才能运行该工具。输入 y,然后按 Enter 键执行提示词。 这将在 Bright Data 基础架构上启动异步 TikTok Scraper 任务。结构化个人资料数据准备就绪后,Ollama 会对其进行处理。

这一次,报告的结果是:

**Profile:**

- **Nickname:** Khabane Lame

- **Verified:** Yes

- **Followers:** 161,100,000

- **Following:** 83

- **Account Created:** August 10, 2016

- **Profile Language:** English

- **Biography:** "Se vuoi ridere sei nel posto giusto. If u wanna laugh u r in the right place"

- **Profile Link:** \[TikTok Profile\](https://www.tiktok.com/@khaby.lame)

**Engagement Rates:**

- **Average Engagement Rate:** 0.61%

- **Like Engagement Rate:** 0.60%

- **Comment Engagement Rate:** 0.009%

**Content Overview:**

- **Total Videos:** 1,293

- **Top Videos Playcount Range:** 1.4M – 209.3M

- **Top Videos Favorites Range:** 1,199 – 287,000

- **Top Videos Comments Range:** 1,035 – 87,000

**Audience Insight:**

- Content is highly comedic and appeals to a global audience seeking light, humorous content.

- Engagement is strong in terms of likes and shares, though comment engagement is comparatively low.

**Collaboration Potential:**

Khabane Lame's massive audience and global appeal make him a strong candidate for brand promotion. However, his niche is humor and viral entertainment. Collaborating on an air conditioner campaign would require a creative, humorous angle that naturally fits his content style. Straight product promotion may not resonate unless tied to comedic or relatable scenarios (e.g., escaping heat in funny ways).如您所见,本报告包含Khaby Lame 的 TikTok 个人资料页面的所有数据,包括互动率等深入分析。

最后的评论强调,所选的网红不一定是推广空调的理想人选,而这正是您想要确定的。

现在,请尝试使用其他提示词,在 Ollama 中探索 Web MCP 的功能!

结束语

在这篇博文中,您了解了如何在 Ollama 中利用 MCP 工具。特别是,您将看到如何使用 Bright Data Web MCP 中的工具来增强本地 Ollama 模型,这些工具可通过 @brightdata/mcp 包在本地运行。@brightdata/mcp 软件包运行。

这种集成使您的模型具备网络搜索、结构化数据提取、实时网络数据订阅、自动网络交互等功能。

要创建更先进的 AI 代理,请探索Bright Data 生态系统提供的全套 AI 就绪型工具和服务。

立即注册一个免费的 Bright Data 账户,开始使用我们的网络数据工具!